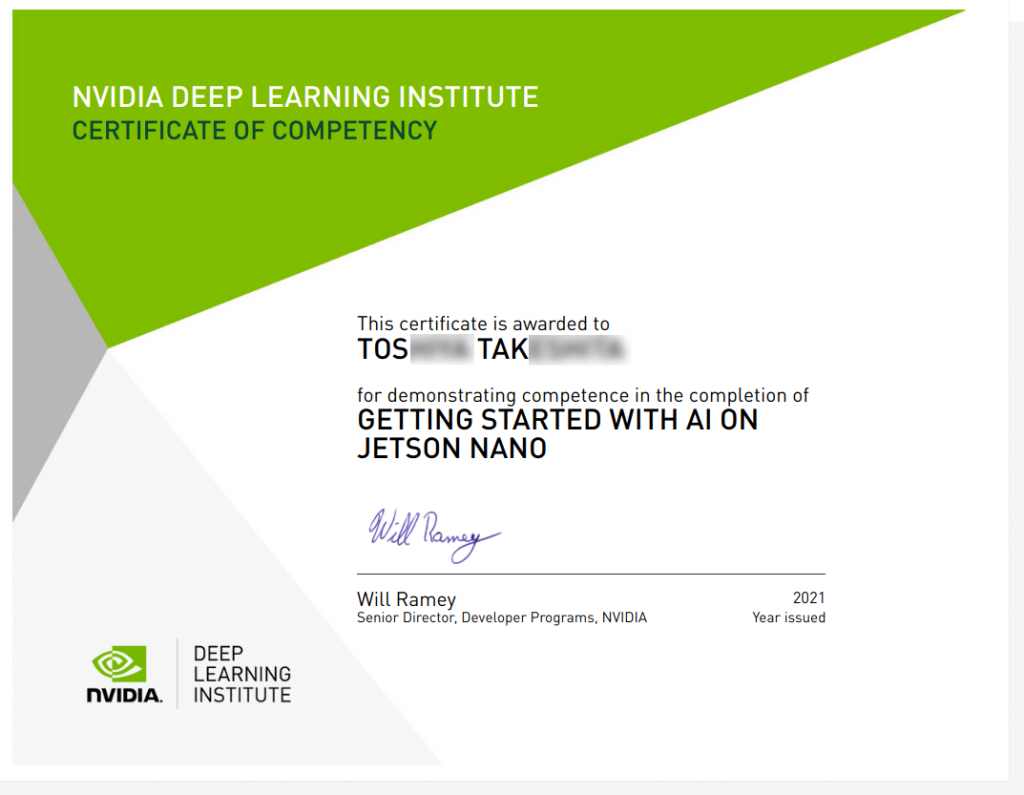

Jetson Nano に Docker + Pytorchコンテナ作成

Jetson Nano にDeep Learning (Pytorch) の環境をDockerで作った時の手順覚え書きになります。

DockerコンテナをGPUを使う前提で起動

echo "docker run --gpus all -it --rm --network host \

--volume ~/nvdli-data:/nvdli-nano/data \

--device /dev/video0 \

nvcr.io/nvidia/dli/dli-nano-ai:v2.0.2-r32.7.1ja" > docker_dli_run.shJetson NanoでGPUを使う時は以前は –runtime nvidia だったようですが、現在は –gpus all になっているようですね。

(-) –runtime nvidia

(+) –gpus all

OS確認

JetPack 確認

cat /etc/nv_tegra_releasenvidia-l4t-coreパッケージのバージョンを確認

dpkg-query --show nvidia-l4t-corePytorchコンテナ

sudo docker pull nvcr.io/nvidia/l4t-pytorch:r32.6.1-pth1.8-py3

sudo docker create -it --gpus all --name=my_torch --network host nvcr.io/nvidia/l4t-pytorch:r32.6.1-pth1.8-py3

sudo docker start -i my_torch

コンテナ使わない場合?

試してないですが、Pytorch環境をダウンロードする方法もあるみたい。

JetPack 4 対応のPyTorch v1.10.0を指定して使いたい時など・・・かな・・・?

pip

python3 -m pip install --upgrade pipコンパイラ

sudo apt install -y --no-install-recommends make g++必要なものをインストール

python3 -m pip install pandas==1.1.1

python3 -m pip install matplotlib==3.3.1

pip3 install jupyterlab以上になります。またお会いしましょう